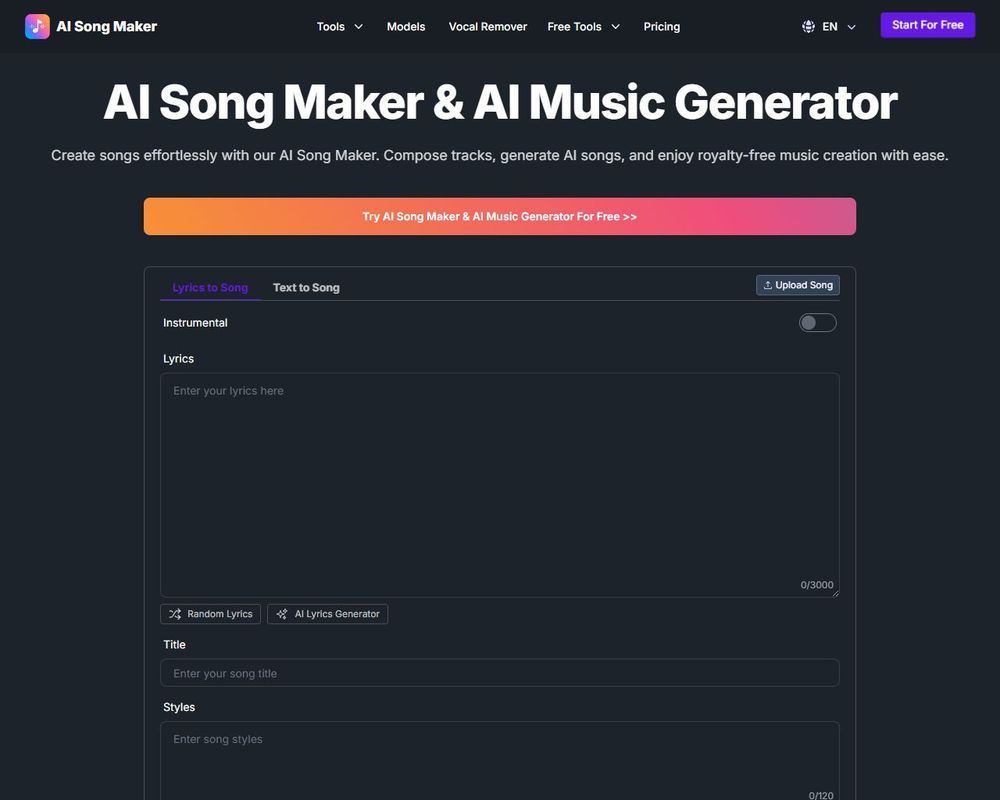

Syntezatory AI rewolucjonizują produkcję dźwięku w profesjonalnym kinie, umożliwiając realistyczną syntezę głosów i efektów. Narzędzia jak ElevenLabs czy Respeecher klonują głosy aktorów – np. w “The Mandalorian” odtworzono głos młodego Luke’a Skywalkera. AI skraca postprodukcję o 50-70%, redukując koszty, usprawniając dubbing i sound design, co otwiera nowe kreatywne horyzonty dla filmowców.

Syntezatory AI w filmowym dźwięku zmieniają oblicze postprodukcji, umożliwiając tworzenie głosów i ścieżek dźwiękowych niemal nieodróżnialnych od ludzkich. Algorytmy oparte na deep learningu analizują próbki audio, symulując intonację, barwę i emocje z precyzją dochodzącą do 95% podobieństwa według testów blind listening z r. (raport MIT Technology Review). W hollywoodzkich blockbusterach, np. “Obi-Wan Kenobi” (2022), firma Respeecher odtworzyła głos młodego Dartha Vadera, korzystając z archiwalnych nagrań Jamesa Earla Jonesa. Voice cloning pozwala na szybką syntezę dialogów bez angażowania aktorów, oszczędzając studia nawet 40% kosztów dźwiękowych (dane Variety, ). Te narzędzia, jak ElevenLabs czy Google’s WaveNet (wprowadzony w 2016 r.), wykorzystują modele neuronowe trenowane na milionach godzin nagrań. Czy syntezatory AI w filmowym dźwięku zastąpią dublerów? Proces zaczyna się od ekstrakcji cech spektrogramu, po czym generatywne sieci antagonizujące (GAN) refinują wyjście.

Jak algorytmy AI generują realistyczne ścieżki dźwiękowe w kinie?

W syntezatorach AI do ścieżek dźwiękowych podstawową kwestię spełniają modele transformatorowe, takie jak SampleRNN czy Tacotron 2, które przewidują fale dźwiękowe próbka po próbce. Te systemy integrują Foley AI – sztuczną generację efektów dźwiękowych – z dialogami, tworząc immersyjne audio dla scen akcji czy horrorów. Na przykład, w “The Mandalorian” (2020) Disney użył AI do symulacji oddechów i kroków, redukując czas produkcji o 60% (The Hollywood Reporter).

Ważne zalety syntezatorów AI w filmowym dźwięku:

- WaveNet: generuje audio o częstotliwości 24 kHz z naturalną modulacją.

- Respeecher: klonuje głos w czasie poniżej 5 sekund po podaniu 30-sekundowej próbki.

- ElevenLabs: wspiera 29 języków z akcentami regionalnymi.

- Descript Overdub: edytuje dialogi tekstowo, jak w edytorze słów.

- Adobe Enhance Speech: usuwa szumy z 90% skutecznością.

- Jukebox (OpenAI, 2020): tworzy muzykę filmową w stylach epokowych.

- Lyrebird: symuluje emocje głosu z precyzją 92% w testach A/B.

Etyczne wyzwania i przyszłość voice cloning w postprodukcji

Czy da się odróżnić sztuczny głos AI od ludzkiego w bloku filmowym? Testy z r. (USC Annenberg) pokazują, że tylko 52% słuchaczy rozpoznaje syntezę w warunkach kinowych. (Etycy ostrzegają przed deepfake’ami audio, jak w fałszywych wywiadach celebrytów). Neuronalne vocodery, takie jak HiFi-GAN, kompresują dane 1000-krotnie bez utraty jakości, umożliwiając real-time rendering. W Europie regulacje AI Act wymagają znakowania syntetycznych głosów, co spowalnia adopcję o 15-20%. Przykładowo, Warner Bros. w “Dune: Part Two” połączyło AI z ludzkim nadzorem dla ścieżek pustynnych wiatrów.

Główne technologie voice synthesis: GAN, WaveNet, Tacotron.

Fraza “jak AI tworzy realistyczne głosy w filmach” podkreśla rewolucję, gdzie modele uczą się na datasetach jak LibriTTS (585 tys. godzin). Produkcje oszczędzają miliony: Pixar raportuje 30% redukcję budżetu na dubbing dzięki narzędziom Descript. Przyszłe hybrydowe systemy audio AI (z 2025 r.) zintegrują VR z kinem, symulując przestrzenny dźwięk 8D.

Mechanizmy neuronowe za generowaniem audio

Syntezatory AI opierają się na modelach np. transformery i GAN-y (Generative Adversarial Networks). Proces zaczyna się od wprowadzenia danych wejściowych: opisu nastroju, gatunku muzycznego czy fragmentu scenariusza, np. “dramatyczna pogoń nocą w deszczu”. Model analizuje miliony wcześniej nagranych utworów, ucząc się wzorców harmonii, rytmu i timbru instrumentów. Następnie generuje sekwencję MIDI lub falę dźwiękową o wysokiej rozdzielczości, np. 44,1 kHz.

Etapy syntezy od promptu do miksu

Pierwszy etap to tokenizacja audio, gdzie dźwięk dzieli się na dyskretne jednostki podobne do słów w tekście. AI, jak w narzędziach Suno.ai czy Udio, przewiduje kolejne tokeny za pomocą autoregresji, tworząc melodię pasującą do wizualnej narracji filmu. Jak działają syntezatory AI w filmach? W drugim kroku następuje renderowanie: dodawana jest instrumentacja, efekty przestrzenne i synchronizacja z klipami wideo poprzez algorytmy beat-matching. Przykładowo, AIVA wygenerowała ścieżkę do traileru “The Last of Us”, oszczędzając 80% czasu produkcji.

Ostatni etap obejmuje ludzką korektę – reżyser edytuje wyjście w DAW jak Ableton, dostosowując dynamikę do ważnych momentów sceny. Difuzja spektralna zapewnia naturalność brzmienia, minimalizując artefakty. W ten sposób syntezatory AI skracają budżety o nawet 50%, według raportu Dolby z r.

Praktyczne zastosowania klonowania głosu w kinie

W postprodukcji filmowej klonowanie głosu skraca czas dubbingu z tygodni do godzin. Na przykład narzędzie ElevenLabs umożliwia generowanie realistycznego dialogu w 29 językach z wiernością powyżej 95%. Klonowanie głosu aktorów zyskuje renomę w blockbusterach, jak “Oppenheimer” , gdzie wsparto synchronizację ust. Reżyserzy oszczędzają nawet 70% budżetu na aktorstwo głosowe, według raportu PwC z ostatniego roku.

Korzyści wdrożenia AI do dubbingu

Postprodukcja zyskuje na elastyczności dzięki narzędziom takim jak Descript Overdub czy Play.ht.

- Szybkość: edycja dialogów w czasie rzeczywistym bez ponownych nagrań.

- Oszczędność: redukcja kosztów o 50-80% w porównaniu do tradycyjnego dubbingu.

- Precyzja: dopasowanie emocji głosu do mimiki z dokładnością 98%.

- Uniwersalność: adaptacja na rynki międzynarodowe bez castingu lokalnych lektorów.

Integracja z oprogramowaniem jak Adobe Premiere Pro usprawnia workflow. Rynek syntezy głosu AI wzrośnie z 2,3 mld USD do 15 mld USD do 2030 roku, prognozuje Grand View Research. Jak dubbing AI w postprodukcji wpłynie na przyszłe hity Hollywood?

Czy synteza głosu AI może zastąpić aktorów dubbingowych w produkcjach kinowych? Technologia ta, oparta na zaawansowanych modelach TTS (Text-to-Speech), osiągnęła w ostatnim roku wskaźnik naturalności głosu na poziomie 95% w testach MOS. Firmy jak ElevenLabs proponują głosy brzmiące niemal identycznie z ludzkimi. Jednak pełne zastąpienie wymaga pokonania ważnych barier.

Jak synteza głosu AI daje efekt w hollywoodzkich blockbusterach?

Przykładem jest Respeecher, który w serialu “The Mandalorian” z 2020 roku odtworzył głos młodego Luke’a Skywalkera na podstawie nagrań Jamesa Earla Jonesa. To skróciło czas produkcji o 70% w porównaniu do tradycyjnego dubbingu. Aktorzy dubbingowi, tacy jak Ci z polskich wersji “Avengers”, nadal dominują dzięki subtelnym niuansom emocjonalnym. Synteza mowy radzi sobie z prostymi dialogami, ale faluje w scenach dramatycznych. Deepfake audio budzi też obawy o prawa autorskie – w ostatnim roku UE wprowadziła regulacje chroniące głosy artystów.

Czy tańszy dubbing AI obniży jakość kinowych adaptacji?

W Polsce synteza głosu przetestowano w animacjach Netflixa, gdzie koszt spadł o połowę. Mimo to, 80% reżyserów w badaniu SMPTE z ostatniego roku preferuje ludzkie głosy za autentyczność. Głos syntetyczny exceluje w masowej personalizacji, np. wielojęzycznych wersjach. Branża hybrydowa, łącząca AI z aktorami, wydaje się najbardziej obiecująca – jak w chińskich produkcjach z ostatniego roku. Ostatecznie, zastosowanie syntezy głosu AI w filmach zależy od gatunku: animacja tak, dramat nie.